| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | |

| 7 | 8 | 9 | 10 | 11 | 12 | 13 |

| 14 | 15 | 16 | 17 | 18 | 19 | 20 |

| 21 | 22 | 23 | 24 | 25 | 26 | 27 |

| 28 | 29 | 30 |

- mariadb

- MSSQL

- API

- Windows

- JavaScript

- MySQL

- Ai

- 영어

- error

- SSL

- 설정

- JS

- AWS

- docker

- React

- Python

- s3

- ssh

- unity

- elasticsearch

- 구글

- Kibana

- 유니티

- sample

- nodejs

- Linux

- logstash

- build

- ChatGPT

- Today

- Total

목록분류 전체보기 (317)

가끔 보자, 하늘.

Windows에서 https로 localhost 테스트하기(feat. React)

Windows에서 https로 localhost 테스트하기(feat. React)

이전에 mac에서 설정하는 법을 설명했었는데(*mac에서 설정하는 법 참고) windows에서는 다른 몇 가지가 있어서 추가로 정리해 봅니다. Powershell에서 설치하는 법만 간략히 정리하니 다른 문의 내용은 댓글로 달아주세요. 우선 윈도우에서 mkcert 설치를 위해 패키지 관리자인 chocolatey를 설치합니다. powershell 관리자모드에서 아래와 같이 실행하세요. Set-ExecutionPolicy Bypass -Scope Process -Force; [System.Net.ServicePointManager]::SecurityProtocol = [System.Net.ServicePointManager]::SecurityProtocol -bor 3072; iex ((New-Object S..

상상으로 그리기 #004

상상으로 그리기 #004

아기 고양이들이 점프 할 때 ... 엄마 고양이처럼 점프는 하고 싶고.. 몸은 안따라주고... 그런 시작이 있기에 또 성장하는거 아니겠나.

python 으로 작업할 때 가끔 마주치는 이슈들 정리

python 으로 작업할 때 가끔 마주치는 이슈들 정리

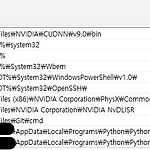

윈도우에서 pip 인식 안될 때 python -m pip ... 이렇게 입력하면 되지만 ... 귀찮죠. 환경변수에 python이 설치된 경로가 등록되어 있을 겁니다. 복사해서 뒤에 "/Scripts"를 추가 등록해 두세요. 아래처럼 등록되어 있으면 됩니다. pytorch 설치 시 cu 버전에 맞게 설치하는 command python -m pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

상상으로 그리기 #003

상상으로 그리기 #003

아내가 막 아이를 가졌을 무렵. 한 겨울 야근에 지쳐 퇴근했는데 아내가 투정부리며 반겨 주었다. 그날은 유난히도 눈이 많이 내린 겨울 밤이었다. 집에 오며 바라본 세상은 적막하기만 했는데 아내와 같이 나간 세상은 주황색 가로등 불빛이 눈에 반사되어 온 세상이 오렌지 빛으로 아름답게 물들어 있었다. 그렇게 아름다울 수가 없었다.

Chat with RTX 사용기

Chat with RTX 사용기

24년 다닌 회사를 곧 퇴사!! 열심히 다녔는데 인계할 내용이 많지는 않네. 게임 개발회사라 지금 내가 하는 인하우스툴 및 서비스, 데이터 엔지니어링 업무를 받을 사람은 없지만 그래도 인수인계는 해야 해서 현재의 동료들에게 전달해야만 하는 상황이다. 비용 아끼려도 남아 있는 시스템으로 구축된 거라 누군가 이 업무를 해야 한다면 외부에 잘 만들어둔 서비스를 쓰라고 강조에 강조를 한다. 하지만.. 우리는 좋... 하여간.. 현재 동료 중 이걸 인수인계할 수 있는 인원들이 없는데다 새로 뽑을 계획이 없는 상황. 그래서 나를 대신해 줄 sLLM이 반드시 필요한 상황이었다. 하지만 이쪽 분야에 대해서는 실무를 해본적이 없기 때문에 구글구글구글링링링.. 참고 자료 https://www.youtube.com/watc..

오래된 윈도우 콘솔 프로젝트를 최신 VC으로 업그레이드 중 “LNK2001 확인할 수 없는 외부 기호 __vsnwprintf_s ...\odbccp32.lib(dllload.obj)” 라는 에러가 발생했습니다. legacy 코드인데 해당 함수를 직접 쓰는 코드도 없는 상태. 기본 CRT 함수라 링크 이슈도 아닌 듯 한데.. 검색해보니 아래 링크에서 관련 이슈를 찾을 수 있었습니다. https://learn.microsoft.com/ko-kr/cpp/porting/overview-of-potential-upgrade-issues-visual-cpp?view=msvc-170#errors-involving-crt-functions 결과적으로 프로젝트 속성에서 구성 속성>링커>입력에 legacy_stdio_de..